MotionDirector:AI定制视频新方法

10月18日 消息:最新研究指出,文本到视频传播模型在最近取得了显著进展,用户只需提供文本描述,就可以创建逼真或富有想象力的视频。这些基础模型还被调整以生成与特定外观、风格和主题匹配的图像。

然而,在文本到视频生成中自定义运动的领域仍需要深入探讨。用户可能希望创建具有特定运动的视频,比如汽车前进然后左转。因此,将扩散模型调整以创建更具体内容以满足用户的需求变得非常重要。

项目地址:https://showlab.github.io/MotionDirector/

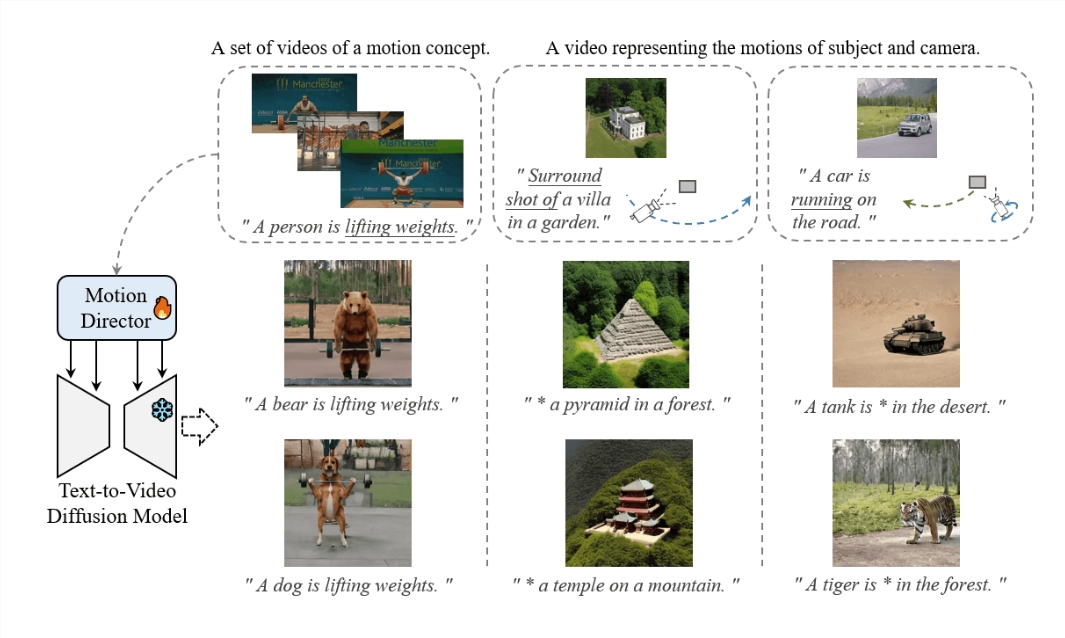

为了解决这一问题,研究人员提出了MotionDirector,这是一种双通道架构的人工智能方法,旨在训练模型学习给定单个或多个参考视频中的外观和运动,使其能够同时实现运动的自定义和外观的多样性。

其中,空间通道包含了一个基础模型,其在每个视频的变换层中集成了可训练的空间LoRAs(低秩适应),这些LoRAs是通过在每个训练步骤中随机选择的单帧来进行训练,以捕捉输入视频的视觉属性。与此相反,时间通道复制了基础模型,与空间通道共享空间LoRAs,以适应给定输入视频的外观。此外,时间通道中的时间变换器还使用从输入视频中选择的多帧进行训练,以捕捉固有的运动模式。

通过部署经过训练的时间LoRAs,基础模型可以合成具有多样外观的学习运动的视频。这种双通道架构使模型能够分别学习视频中物体的外观和运动,从而使MotionDirector能够隔离视频的外观和运动,然后从不同的源视频中进行组合。

研究人员通过在多个基准数据上比较MotionDirector的性能,包括80多种不同的运动和600个文本提示。在UCF体育动作基准测试中,MotionDirector被人工评定者约75%的时间选择,以获得更好的运动保真度,该方法还胜过了25%的基准模型的首选项。

在第二个基准测试中,即LOVEU-TGVE-2023基准测试中,MotionDirector表现优于其他可控生成和调整方法。这些结果表明,MotionDirector可以定制多个基础模型,以生成具有多样性和所需运动概念的视频。

总之,MotionDirector是一种有潜力的新方法,可用于调整文本到视频传播模型,以生成具有特定运动的视频。它在学习和适应物体和摄像机的特定运动方面表现出色,并可以用于生成具有各种视觉风格的视频。

尽管在学习参考视频中多个主体的运动方面仍有改进空间,但即便存在这些限制,MotionDirector仍有潜力增强视频生成的灵活性,使用户能够制作符合其需求的定制视频。