首个多模态开放世界检测大模型MQ-Det登场,精确率提升7.8%(多模态融合)

10月18日 消息:MQ-Det是一款革命性的多模态开放世界检测大模型,在NeurIPS2023首次亮相,引起广泛关注。该模型的核心创新在于融合了文本描述和视觉示例查询,以显著提升目标检测的精确率,整体性能提高了7.8%。

论文链接:https://arxiv.org/abs/2305.18980

代码地址:https://github.com/YifanXu74/MQ-Det

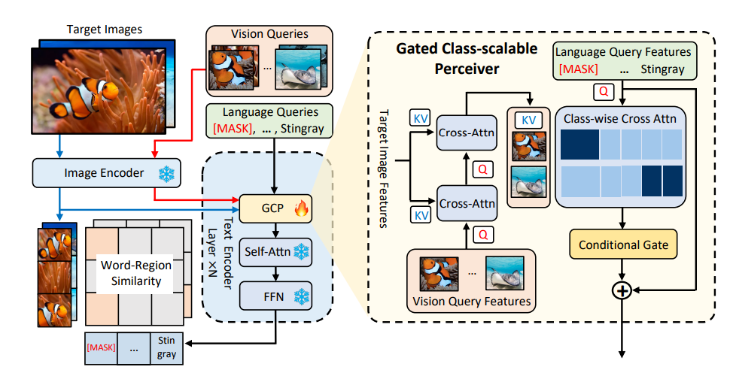

以往的目标检测模型主要采用文本查询的方式,通过类别文本描述在图像中查找目标。然而,这种方式存在一个问题,即无法处理细粒度的目标信息以及类别歧义。MQ-Det通过引入视觉示例查询功能,弥补了这些问题。视觉示例可以提供更丰富的目标特征线索,同时文本查询具有强大的泛化性能。MQ-Det的设计结合了这两种查询方式,使用户可以更灵活地适应不同场景的需求。

MQ-Det的设计包括门控感知模块(GCP)和视觉为条件的掩码语言预测训练策略。GCP模块嵌入在已有文本查询检测大模型中,用于接收视觉示例的输入,提升检测器的多模态查询性能。此外,MQ-Det采用了一种视觉为条件的掩码语言预测训练策略,解决了模型学习惰性的问题,从而更好地利用新加入的视觉查询特征。

实验结果表明,MQ-Det的性能在开放世界目标检测中表现出色。不仅支持传统的finetuning-free评估策略,还在小样本检测任务上表现出色。在LVIS基准数据集上,MQ-Det实现了显著的性能提升,特别是在GLIP精度上提高了超过7%。这表明多模态查询目标检测具有巨大的前景,可用于实际应用领域,弥补了以往文本查询模型在细粒度信息方面的不足。MQ-Det的问世为多模态目标检测带来了新的机遇,为开放世界检测领域注入了新的活力。