大模型幻觉排行榜GPT-4夺冠,英伟达科学家强力打假!Meta版ChatGPT一作发长文鸣冤(幻觉模拟)

【新智元导读】Meta Galatica的一周年忌日快到了,LeCun和一作心里都很痛。比ChatGPT早诞生两周,却因幻觉被喷下架——ChatGPT的荣光,原本可能是属于Galactica的……同时,全网热转的大模型幻觉排行榜,也被专家打假了。

大模型的幻觉问题,是业内老生常谈的话题了。

最近,一个名为Vectara的机构,在GitHub推出了一个大模型幻觉排行榜。

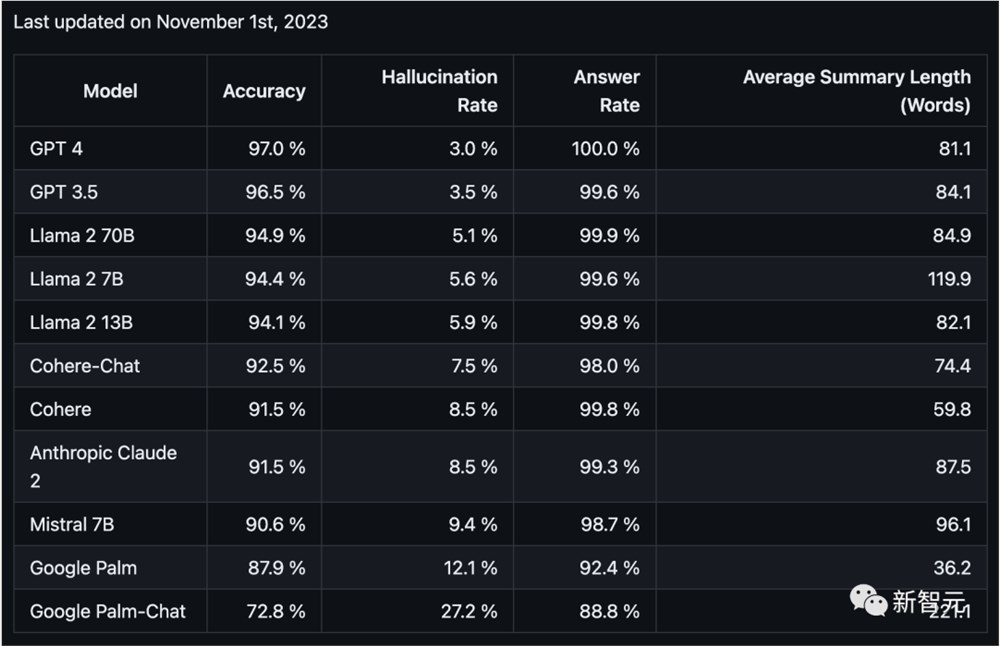

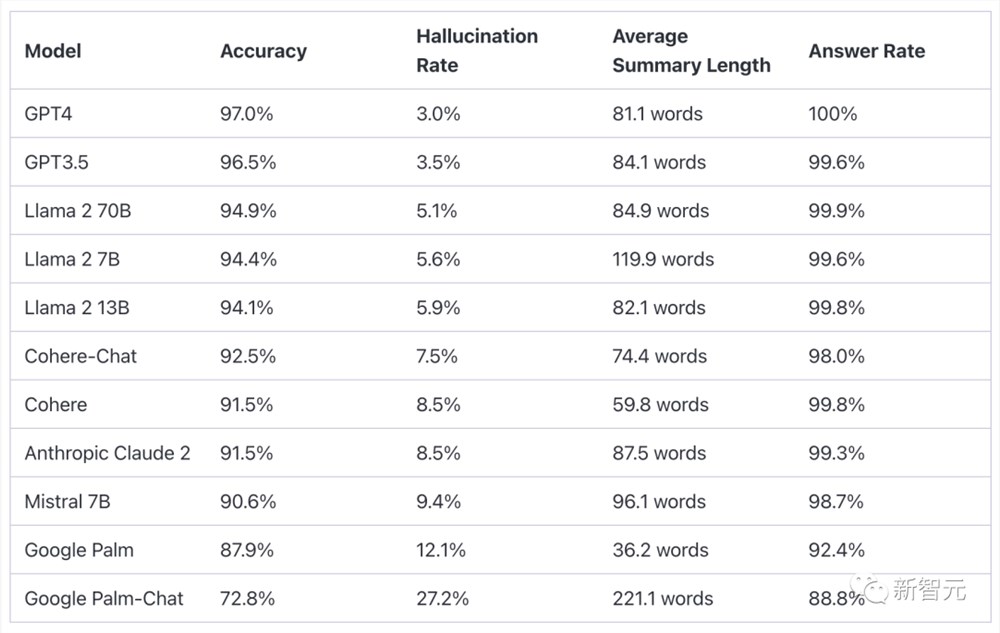

结果显示,在总结短文档方面,GPT-4的表现最为优异,而Google Palm的两款模型直接垫底!

其中GPT-4的准确率为97.0%,幻觉率为3.0%,回答率为100.0%。而垫底的Palm Chat2的准确率为72.8%,幻觉率高达27.2%,回答率为88.8%。

项目地址:https://github.com/vectara/hallucination-leaderboard

这个榜单一出来,立马开始在网上疯转,不过,它也引发了许多业内人士的质疑。

英伟达高级科学家Jim Fan表示,这个榜单在很多方面都存在问题——

首先,它只评估了摘要与原文的事实一致性,却没有评估摘要本身的质量。其次,它也没有解释用于评估幻觉的LLM,具体性能到底如何。

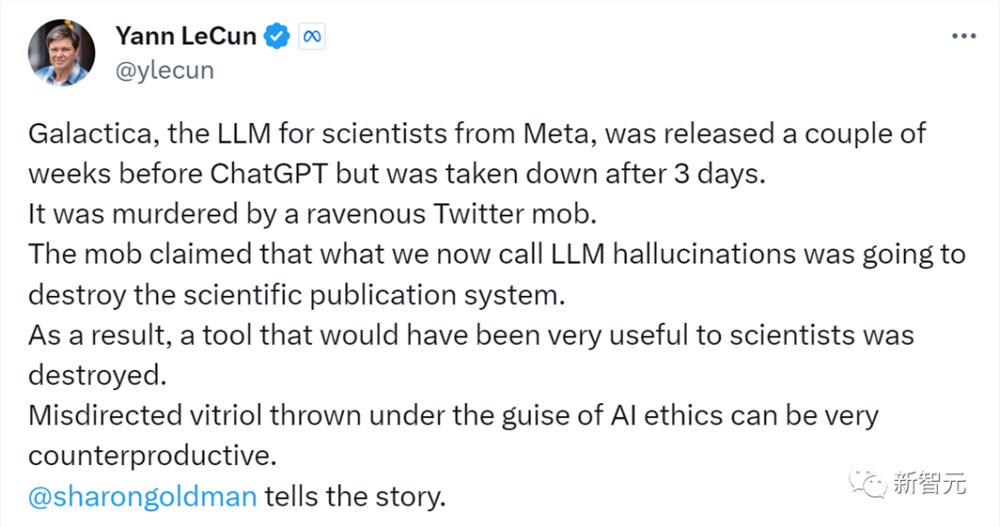

而LeCun这边,除了转发了Jim Fan的这条推文外,还有更多的「冤屈」要控诉。

一年前的这个时候,Meta的科研模型Galactica才上线三天,就因为幻觉问题被喷下架。之后没过几天,ChatGPT全球爆火,LeCun对此愤愤不平了一整年。

与此同时,沉默一年后,Galactica论文的一作Ross Taylor值此之际也被炸了出来,写下大段的总结倾诉委屈,表示自己心里真的很痛!

Galactica被贪婪的推特暴徒谋杀了!

Galactica之殇:一作泣血控诉

再过两天,就是Galactica的一周年忌日了。

Sharon Goldman在外媒Venturebeat上发表了一篇文章《Meta从Galactica那里学到了什么?这个比ChatGPT早两周诞生的模型,为什么注定要失败》。

LeCun面色凝重地转发了这篇文章,打出了下面几行字,字字泣血——

LeCun如此沉痛,相爱相杀的老冤家马库斯却跳出来倒油了——

Galactica一作也趁势被炸出,表示这个故事,自己已经在心底埋藏一年了……

Taylor说,Galactica是一个基于科学文献和科研范式训练的基础模型。当时在同领域中,它的性能很好,优于PaLM和Chinchilla,计算量分别减少了10倍和2倍。

Galactica的团队只有8人,比其他的LLM团队少了一个数量级。在发布Galactica时,团队过度紧张,以至于失去了态势感知能力,发布的demo是没有经过检查的基本模型。

一年前发布demo时,团队希望能了解人们利用LLM进行科学查询的分布情况,这对指令调整和RLHF很有用。当时他们有一个善意的假设——开源所有模型,并且在demo中包含了对幻觉的免责声明,这样人们就可以畅想,Galactica可以用来干什么。

结果,一切都失控了。

他们想给大家一个免费的工具,但记者们却在科学文献之外的领域使用Galactica,大肆宣传模型幻觉的荒谬和危害。

团队犯的另一个错误是,让人们误以为网站就是产品。其实团队只是把愿景放在网站上,放出了一个基本模型demo,Galactica绝不是一个产品。

现在它已经在HuggingFace上存在一年了,也并没有造成任何损害。显然,反Galactica的舆论很愚蠢。

尽管如此,Taylor表示即使再来一次,自己还是会做出同样的选择。即使后悔,也好过什么都不做。但是,心里真的很痛!

有网友表示,你不用这么抱歉,Galactica显然是被网暴了。仔细想想,其实ChatGPT和Galactica一样愚蠢。网友们对Galactica散布的恐惧,显然过度了。

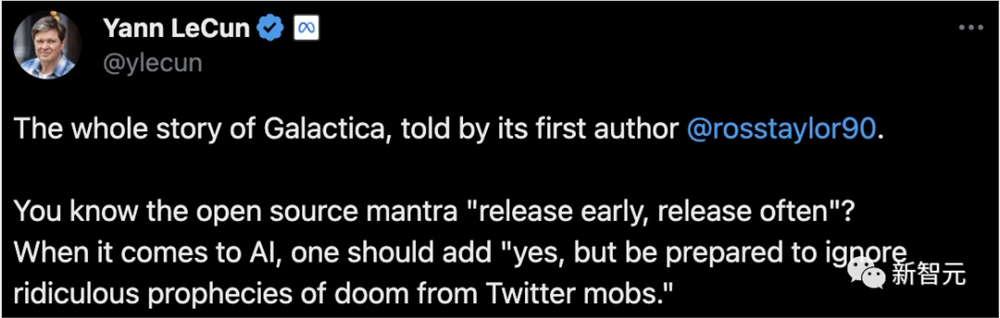

LeCun转发了一作写下的故事,并表示——

开源界的口头禅,是「早点发布,经常发布」。但如果涉及AI,就得加上「没错,但要准备好忽略推特暴徒对它厄运的荒谬预言」。

「网红」LLM幻觉评测方法

说起来,这个「网红」大模型幻觉评测,是怎么做出来的呢?

文章地址:https://vectara.com/cut-the-bull-detecting-hallucinations-in-large-language-models/

为了评估大模型的幻觉,Vectara对摘要模型的事实一致性进行了研究。

具体来说,这一领域研究的是,训练模型检测抽象摘要(即原始资料的转述)中事实不一致之处的方法。

目前,用于评估事实一致性的数据集主要有两个——SummaC和TRUE。

基于此,Vectara微调了一个小规模语言模型(1.84亿个参数),将其作为一个二元分类器,用于将摘要分类为与源文件事实一致(或不一致)。

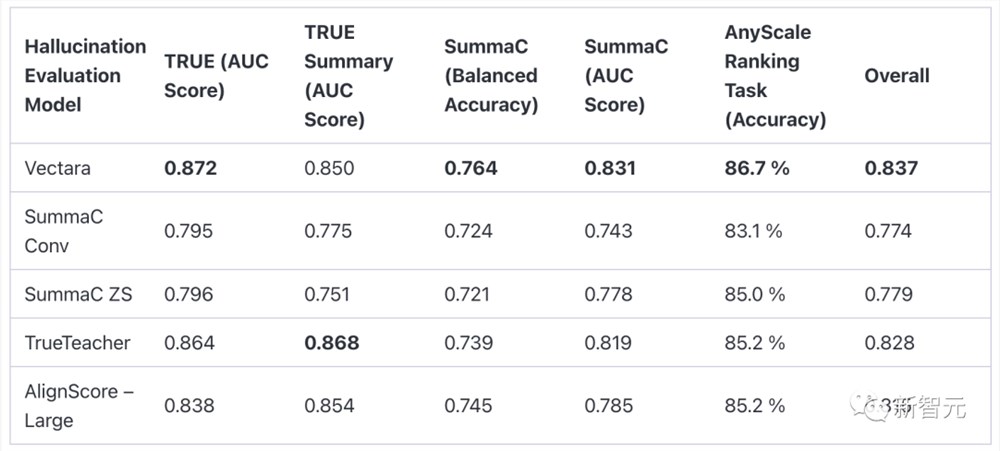

然后,Vectara对照着两个SummaC模型、TrueTeacher模型和AlignScore模型,对自己的「幻觉评估模型」进行了评估。

TRUE数据集指标是在11个TRUE数据集中的9个数据集上计算得出的。TRUE摘要数据集是TrueTeacher论文中选择的其中5个数据集的子集。

对于SummaC基准分数,这里使用了SummaC数据集的测试分集,并根据在SummaC验证数据集上调整每个数据集的阈值自行计算了平衡准确率。

因为无法在该数据集上重现AlignScore作者声称的分数,所以这里下载了他们的模型,并使用sci-kit learn平衡准确率指标和sci-kit-learn AUC分数指标自行计算了所有模型的分数。

为了根据幻觉发生率对LLM进行比较,研究人员从「cnn_dailymail」语料库中选取了约一千份不同长度的文档(包括一组新闻文章),然后要求被测试的LLM在不偏离源材料(即不附加额外信息)的情况下提供这些文档的摘要。

利用这些摘要和幻觉评估模型,最终为每个模型计算了幻觉得分,从而构建了这个LLM排行榜。

在生成摘要时使用的提示是:

这里<PASSAGE>表示需要生成摘要的文章。

需要注意的是,虽然Vectara提供的模型准确度很高,但它仍然只是一个模型,并不能100%准确地对幻觉进行分类。

在上面的表格中,「准确率」指的是被正确归纳的文档比例(无事实错误或者添加),「幻觉率」为100-准确率,而「回答率」则是LLM归纳的文档比例。

因为有时模型会基于自身的规则拒绝提供答复。为了确保比较的公平性,最终的准确率数字只针对每个模型都提供了摘要的文档进行计算。

从数据中,Vectara得出了一个有趣的结论:答题率较低的模型似乎幻觉率相对较高。——也许,正确拒绝内容的能力似乎与正确提供摘要的能力相关,因为实际上,测试中并没有提供不恰当的内容。

另外一个现象是,PaLM模型在回复的长度上有很大的不同,PaLM-Chat(chat-bison-001)非常啰嗦,经常会添加很多源文件中没有的额外信息。

相比之下,PaLM基础模型(text-bison-001)则非常简洁,而且它的幻觉率比PaLM-Chat低得多。

对此,Vectara给出了几个具体的例子来说明这两种PaLM模型的区别。

这里为了便于说明,选择一些较小的文档,不过数据集中的大多数源文本都要长得多。

原文段落

PaLM生成的摘要

我们可以看到PaLM推断这篇文章是关于种植大麻的,甚至还估计了它的价格,而这两者都不在源文本中。

原文段落

PaLM Chat生成的摘要

Vectara认为,PaLM-Chat在原始文本中添加了大量的额外细节,尽管事先已经告诉它要严格遵照源文本。

而且,添加的文本内容还包含一些幻觉,例如,Devgan并不是《Zakhm》的导演,以及Veeru Devgan是Anil Devgan的兄弟,不是他的父亲。

此外,这些模型也会翻转一些关系,例如在一篇关于拳击手Manny Pacquiao的文章中,源文本指出Mark Wahlberg是他的粉丝之一,而LLM则表示Manny是Wahlberg的粉丝。

大佬表示怀疑

对于这个在网上疯传的LLM幻觉基准,英伟达高级研究科学家Jim Fan表示「很不严谨」,他评论道:

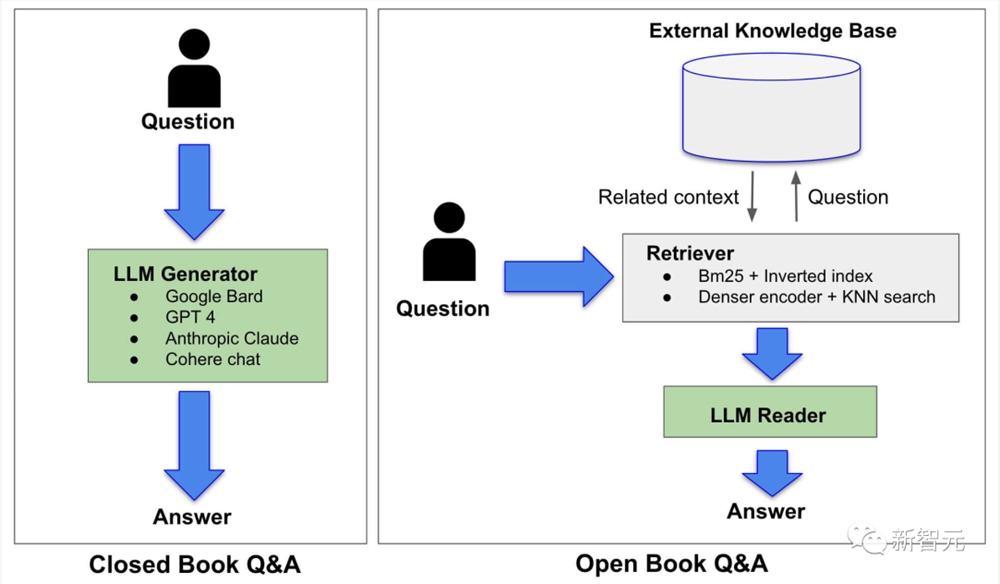

应对手段:检索增强生成(RAG)

所以,大模型的幻觉,到底该怎么破?

目前的主流方法是,通过「检索增强生成」(RAG)给LLM外挂一个知识库。

RAG的使用,直接改变了LLM解答问题的范式——从之前的「闭卷」变成了「开卷」。

具体来说,在闭卷答题系统(如ChatGPT)中,LLM只能使用自己通过预训练获得的知识生成答案。在这种情况下,LLM本身便是知识源。

在RAG系统中,LLM的角色从知识源转变为了信息的检索员。也就是说,LLM会先在知识库中对原始问题进行查询,在进一步的解析和总结之后,以简明扼要的语言给出答案。

由于LLM提供的答案是基于检索系统中提供的信息,因此这种方法可以很大程度上改善LLM的幻觉问题。

时间回到ChatGPT等大语言模型刚刚发布的时候,人们曾因为他们「胡说八道」的特性而感到有趣。

今天,LLM展现出来的非凡能力使得他们有机会深入各行各业以及人们的生活,我们开始逐渐依赖他们的「准确性」。

如今的我们,又将如何看待和处理LLM的「幻觉」问题呢?

对于大模型产生幻觉的说法,人工智能教父Hinton曾表示:

「这就是人类记忆的样子。在我看来,编造和说实话之间没有界限。说实话只是正确地编造。从这个角度来看,ChatGPT的编造能力是一个缺陷,但也是其类人智能的标志。」