元象XVERSE开源650亿参数通用大模型XVERSE-65B(元象国际)

11月6日 消息:元象XVERSE宣布 开源650亿参数高性能通用大模型XVERSE-65B,无条件免费商用。

XVERSE-65B 是由深圳元象科技开发的一种支持多语言的大型语言模型。它采用了 Transformer 网络结构,参数规模达到了650亿。

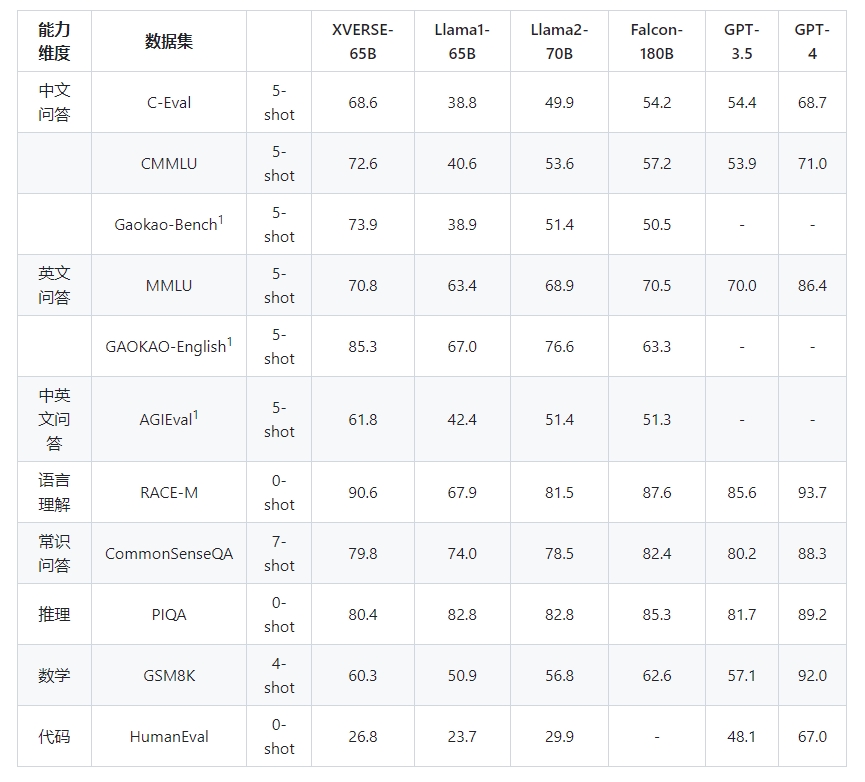

模型通过训练了2.6万亿个令牌的高质量多样化数据,包含了40多种语言。XVERSE-65B 具有16K 的上下文长度,适用于多轮对话、知识问答和摘要等任务。模型已在多个标准数据集上进行了测试,并取得了良好的性能。

主要特点如下:

模型结构:XVERSE-65B 使用主流 Decoder-only 的标准 Transformer 网络结构,支持16K 的上下文长度(Context Length),能满足更长的多轮对话、知识问答与摘要等需求,模型应用场景更广泛。

训练数据:构建了2.6万亿 token 的高质量、多样化的数据对模型进行充分训练,包含中、英、俄、西等40多种语言,通过精细化设置不同类型数据的采样比例,使得中英两种语言表现优异,也能兼顾其他语言效果。

分词:基于 BPE(Byte-Pair Encoding)算法,使用上百 GB 语料训练了一个词表大小为100,534的分词器,能够同时支持多语言,而无需额外扩展词表。

训练框架:自主研发多项关键技术,包括高效算子、显存优化、并行调度策略、数据-计算-通信重叠、平台和框架协同等,让训练效率更高,模型稳定性强,在千卡集群上的峰值算力利用率位居业界前列。

项目地址:https://github.com/xverse-ai/XVERSE-65B